Никакой телепатии: протез декодирует сигналы речевого центра головного мозга, чтобы предсказать, какой звук пытается произнести человек.

Речевой протез, разработанный совместной командой нейробиологов, нейрохирургов и инженеров Университета Дьюка, может преобразовывать сигналы человеческого головного мозга в то, что пытается сказать человек.

Новая технология, о которой 6 ноября сообщил журнал Nature Communications, однажды может вернуть людям, лишившимся из-за неврологических расстройств речи, способность общаться, используя интерфейс мозг — компьютер.

«Есть много пациентов с изнурительными моторными расстройствами, способными серьёзно ухудшить речь, такими как БАС (боковой амиотрофический склероз) или синдром запертого человека, — отмечает доктор философии Грегори Коган (Gregory Cogan), профессор неврологии в Медицинской школе Университета Дьюка и один из ведущих участников данного технологического проекта. — Однако доступные инструменты, помогающие общаться, как правило, громоздкие и работают очень медленно».

Представьте, что вы слушаете аудиокнигу на половинной скорости. В настоящее время именно такая скорость (около 78 слов в минуту) является наилучшей при декодировании речи, тогда как обычно люди произносят в минуту примерно 150 слов.

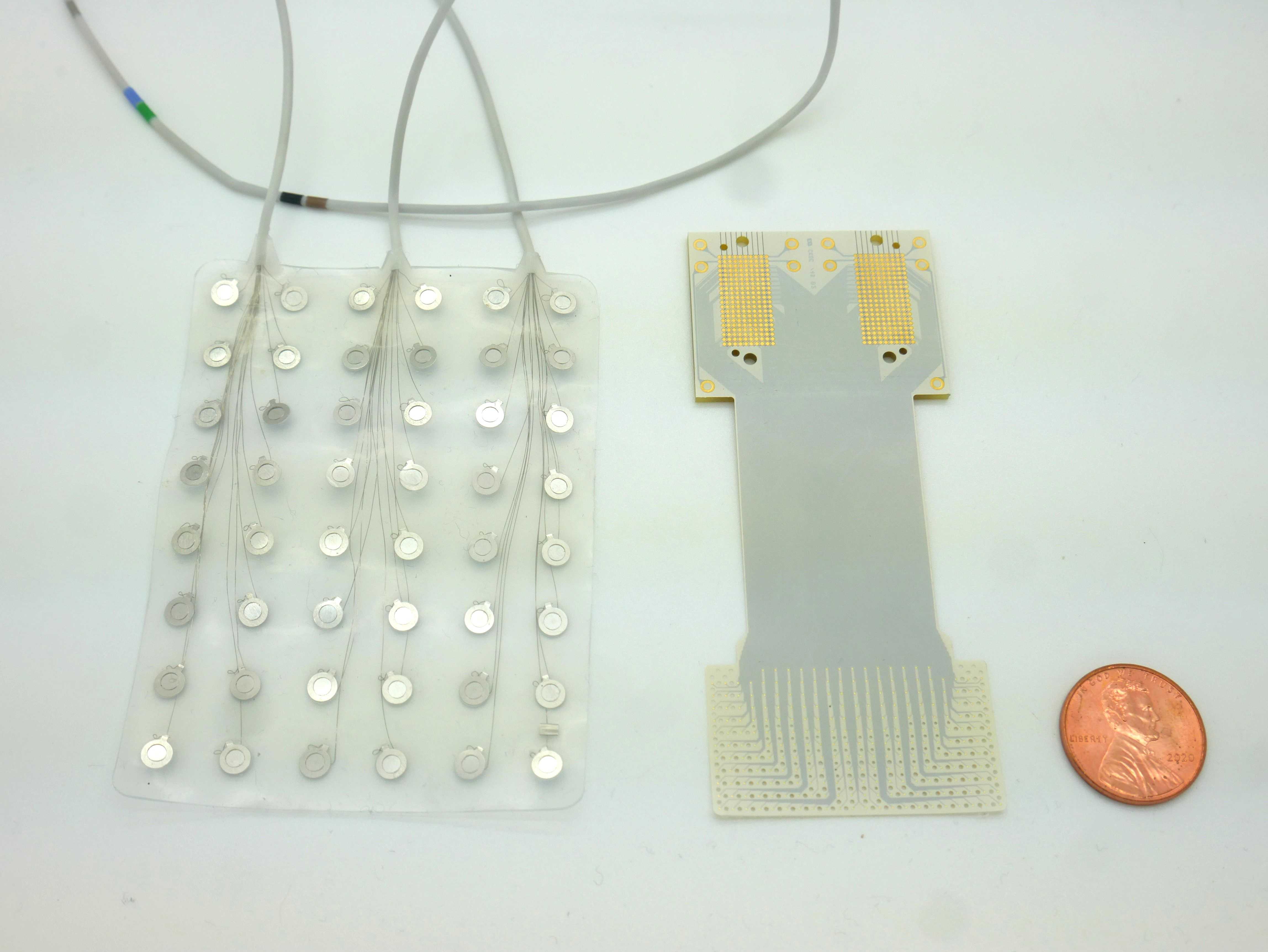

Эта разница в скорости между произнесённой и декодированной речью отчасти обусловлена относительно небольшим количеством датчиков мозговой активности, которые можно встроить в тонкую, как лист бумаги, пластину, лежащую на поверхности головного мозга. Чем меньше датчиков, тем меньше доступной для расшифровки информации.

Чтобы устранить существовавшие ограничения, Коган объединился с постдокторантом Дьюкского института наук о головном мозге (Duke Institute for Brain Sciences) доктором философии Джонатаном Вивенти (Jonathan Viventi), чья лаборатория биомедицинской инженерии специализируется на создании высокоплотных, ультратонких и гибких мозговых сенсоров.

Для данного проекта Вивенти и его команда разместили на кусочке гибкого медицинского пластика размером с почтовую марку впечатляющие 256 микроскопических мозговых датчиков. При координации речи даже нейроны, расстояние между которыми не больше песчинки, могут иметь совершенно разные паттерны активности, поэтому точный прогноз того, что будет сказано, требует различать сигналы, идущие от соседних клеток головного мозга.

«Мне нравится сравнивать эту работу с работой пит-экипажа NASCAR, — говорит Коган. — Чтобы не удлинять время операции, мы должны были укладываться в 15 минут. Едва услышав команду хирурга и его медицинской бригады “Пошли!”, мы бросались вперёд, и пациент успевал выполнить поставленную перед ним задачу».

Грег Коган, доктор философии.

Изготовив новый имплант, Коган и Вивенти наладили контакт с несколькими нейрохирургами больницы Университета Дьюка, включая доктора медицины и философии Дерека Саутвелла (Derek Southwell), доктора медицины и философии Нандана Лэда (Nandan Lad) и доктора медицины Аллана Фридмана (Allan Friedman), которые помогли найти четырёх пациентов для тестирования имплантов. Эксперимент требовал от исследователей временно помещать устройство на голове пациентов во время проведения операции на головном мозге, необходимой для удаления опухоли или лечения такого заболевания, как, например, болезнь Паркинсона. У Когана и его команды было мало времени для тестирования их устройства в операционной.

Задача сводилась к простому прослушиванию и повторению. Участники должны были выслушать ряд бессмысленных слов, таких как «ava», «kug» или «vip», а затем каждое из них произнести вслух. Сенсорное устройство регистрировало активность речевой моторной коры головного мозга пациентов. Эта кора координирует работу почти 100 мышц, приводящих в движение губы, язык, челюсть и гортань.

Впоследствии Сусеендракумар Дурайвел (Suseendrakumar Duraivel), первый автор последнего отчёта и аспирант биомедицинской инженерии в Университете Дьюка, взял нейронные и речевые данные из хирургического кабинета и ввёл их в алгоритм машинного обучения, чтобы узнать, с какой точностью алгоритм, опираясь только на записи активности головного мозга, может предсказать появление того или иного речевого звука.

Для некоторых участников и звуков, таких как /g/ в слове “gak”, правильность предсказаний этого декодера составила 84%, если звук был первым в цепочке из трёх, образующих бессмысленное слово.

Однако точность предсказаний падала, когда декодер анализировал звуки в середине или в конце бессмысленного слова. Кроме того, возникали проблемы при анализе двух похожих звуков, например /p/ и /b/.

В целом, точность предсказаний декодера составила 40%. Этот результат может показаться скромным, но, на самом деле, он весьма впечатляющий, так как, чтобы достичь подобных технических результатов преобразования нейронной активности в речевые звуки требуются, как правило, данные, на получение которых уходят часы и даже дни. А вот у Дурайвела алгоритм декодирования речи работал всего лишь с речевыми данными продолжительностью 90 секунд, взятыми из 15-минутного теста.

Дурайвел и его наставники в восторге от того, что благодаря гранту, недавно предоставленному Национальными институтами здравоохранения (National Institutes of Health), им выделят на создание беспроводной версии их устройства 2,4 миллиона долларов.

«Сейчас мы разрабатываем записывающие устройства такого же типа, но беспроводные, — говорит Коган. — Тут восхитительно то, что можно будет передвигаться без оглядки на электрическую розетку».

Хотя исследовательская работа Вивенти и Когана внушает оптимизм, до появления их речевых протезов на прилавках магазинов пока далеко.

«Мы всё ещё находимся на той стадии, когда производимое нами декодирование намного медленнее, чем течение естественной речи, — отметил Вивенти в недавней статье, опубликованной в Duke Magazine, — но уже видна траектория, движение по которой позволит достичь конечного результата».