Создана первая компьютерная модель, которая «видит» и «слышит» одновременно, как человек. Ее основой стали нейронные вычисления, впервые обнаруженные… у насекомых. Открытие объясняет известные иллюзии и открывает широкие перспективы для искусственного интеллекта.

Ученые впервые создали компьютерную модель, которая обрабатывает звук и изображение так же, как это делает человеческий мозг – одновременно. Разработанная система не только объясняет, почему мы поддаемся известным иллюзиям вроде эффекта чревовещателя, но и открывает новые горизонты для создания более эффективного и «человечного» искусственного интеллекта.

Когда мы смотрим на говорящего человека, наш мозг бессознательно и безупречно объединяет движение губ со звуком речи. Этот процесс настолько автоматический, что им можно манипулировать – знаменитой иллюзии Мак-Герка, когда человеку показывают артикуляцию одного слога (например, «га-га»), а в аудиодорожке звучит другой («ба-ба»), он начинает «слышать» несуществующий третий вариант («да-да»). А в иллюзии чревовещания мы невольно связываем голос кукловода с губами куклы.

Долгое время не существовало компьютерной модели, способной объяснить этот механизм на основе реальных сигналов, а не абстрактных параметров, заданных программистом. До сих пор ни одна система не могла решить эту, казалось бы, простую задачу – ежемоментно проверять, совпадает ли звук с изображением артикуляции.

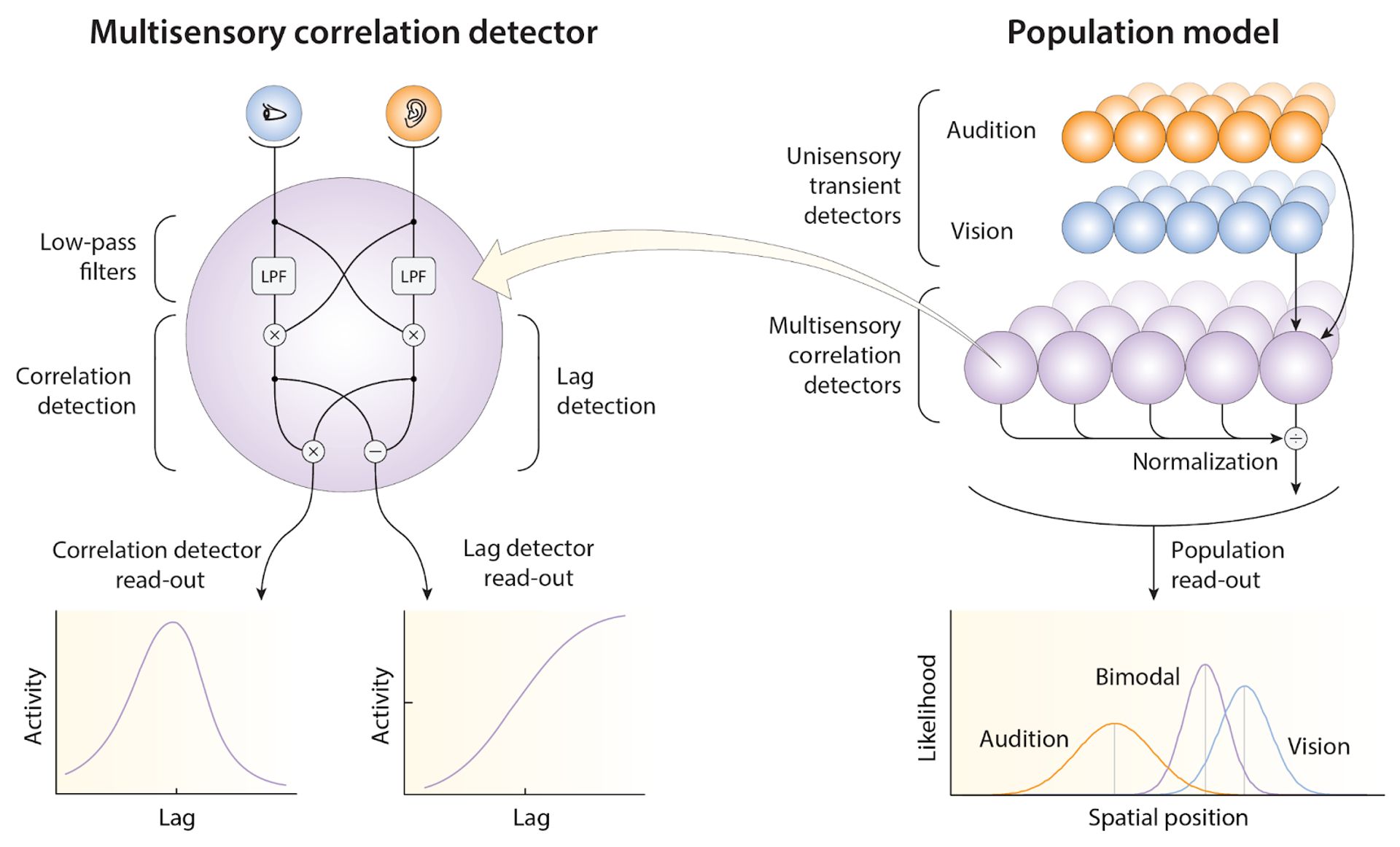

Секрет оказался в нейронных схемах насекомых. Их зрительная система использует так называемый «детектор корреляции», который сравнивает сигналы от соседних рецепторов, чтобы определить направление движения. Исследователи решили, что этот принцип может лежать в основе объединения сигналов от разных органов чувств. Они разработали мультисенсорный корреляционный детектор, а затем создали целую «решетку» из таких детекторов, которая анализирует звук и изображение одновременно в пространстве и времени.

Чтобы доказать свою эффективность, модель протестировали на данных 69 классических экспериментов по аудиовизуальному восприятию, проведенных на людях, обезьянах и крысах.

Кроме того, модель смогла предсказать, куда будет направлен взгляд человека при просмотре фильма, выступая в роли упрощенной «карты внимания», а еще преимущество модели – вычисляемость. Она работает напрямую с «сырыми» аудиовизуальными сигналами, а не с заранее подготовленными данными. Это открывает огромные возможности для искусственного интеллекта, который пока с трудом объединяет информацию из разных источников.

Так что понимание модели зрительного восприятия мухи теперь объясняет, как мозг создает единую картину мира из звуков и образов. Это открытие не только углубляет наше понимание работы мозга, но и предлагает элегантное и мощное решение для технологий будущего.

Достижение опубликовано в журнале eLife.

Текст: Дарья Тюльганова