Исследователи из Китая предложили модульную многопоточную нейронную сеть, которая на основе нейронных записей синтезировала речь на тоновом языке.

С ее помощью удалось декодировать восемь тоновых слогов китайского языка. Авторы показали, что их метод точнее, чем классические базовые методы глубоких нейронных сетей. Исследование опубликовано в Science Advances.

Для пациентов с потерей речи пробуют разрабатывать нейроинтерфейсы, которые преобразуют сигналы мозга в текст или в синтезированную речь. Для этого людей могут просить произнести что-то (если это невозможно, то хотя бы представить, что произносят), и записывают активность моторной коры. Во время артикуляции в ней активируются области, отвечающие за движение языка, губ, челюстей, гортани. Нейронные сигналы именно из этих областей нужны, чтобы затем на их основе синтезировать речь.

С тоновыми языками это проделать сложнее, поскольку один слог на таких языках может иметь несколько значений в зависимости от высоты тона. Различия в артикуляции тоновых слогов очень тонкие, то есть декодирование такой речи должно быть достаточно точным, чтобы хорошо различать моторные сигналы, связанные с тоном — в основном это сигналы от гортани.

Янь Лю (Yan Liu) из Национального центра неврологических расстройств в Шанхае и его коллеги разработали нейронную сеть, которая синтезирует речь из инвазивных записей мозга.

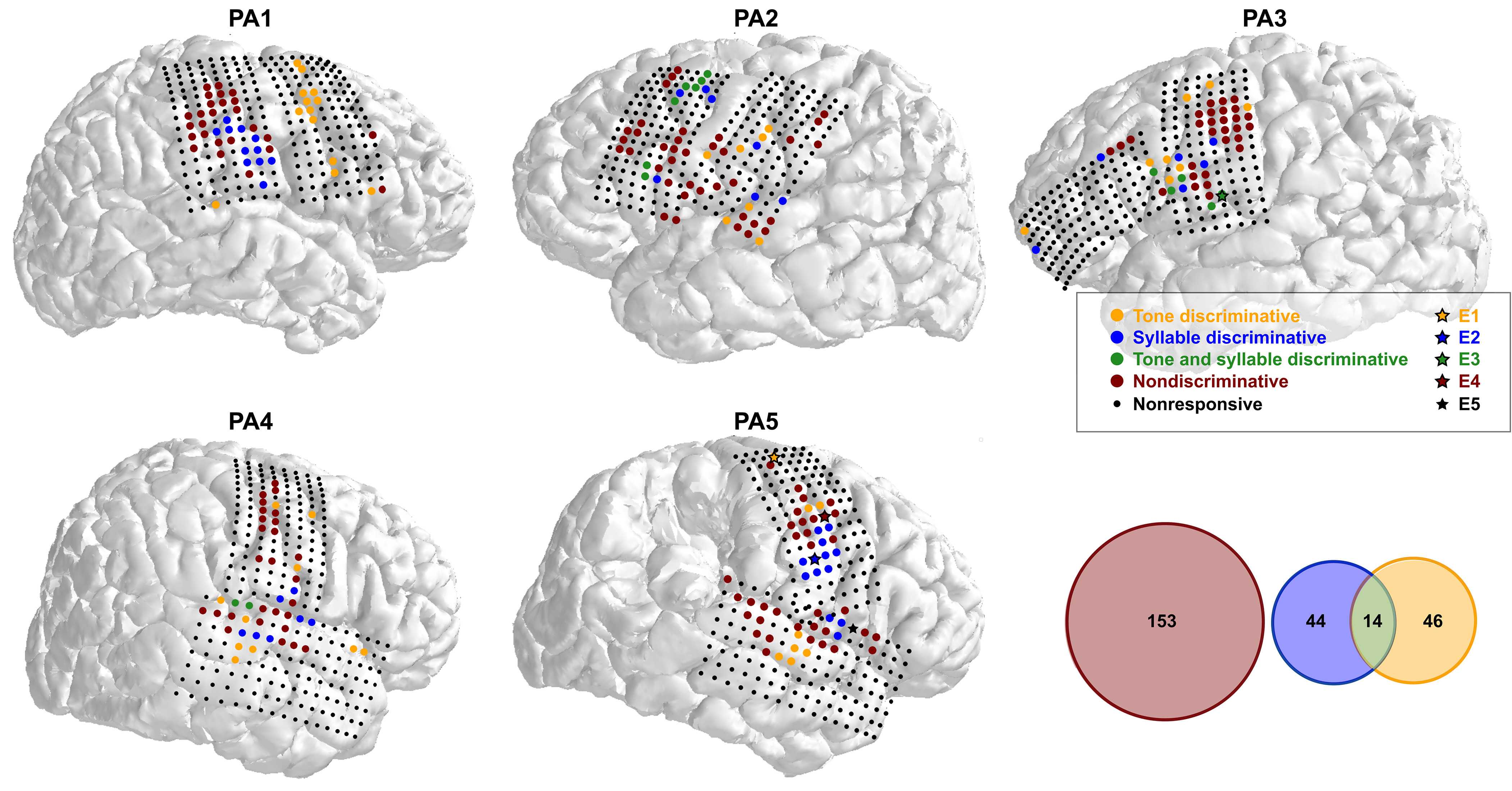

Электроды для считывания электрокортикограммы (ECoG) временно разместили на поверхности мозга пяти пациентов (четырех мужчин и одной женщины) во время операций по удалению опухоли мозга. Во время операций пациенты были в сознании — это было необходимо, чтобы не задеть функционально-значимые области мозга. Участников попросили произносить по очереди восемь тональных слогов на севернокитайском языке — четыре тона слога ma и четыре тона слога mi.

Часть электродов различало слоги, другая часть тона, и совсем немного — и то, и другое. Большинство электродов не различало ни слоги, ни тона — то есть считывали сигналы нейронов, которые активировались, когда человек что-то произносил. С этих электродов можно было получить информацию о тембре, интенсивности и продолжительности звука, что не менее важно для синтеза речи.

Чтобы превратить сигналы из записей ECoG обратно в речь, ученые разработали модель многопоточной сверточной нейросети (CNN) с модулями долгой краткосрочной памяти (LSTM). Модель состояла из двух частей — генератора и синтезатора. Генератор обрабатывал сигналы с электродов, различающих тона и слоги, и на их основе создавал метки слогов и тонов. Синтезатор объединял эти метки с сигналами, полученные от электродов, которые не различали тона и слоги, и создавал мел-спектрограмму речи. Далее эту спектрограмму ученые преобразовывали в звуковую волну с помощью алгоритма Гриффина — Лима.

Для создания меток слогов ученые использовали последовательную сеть CNN-LSTM, а для создания меток тонов — параллельную сеть CNN-LSTM, то есть тона и базовые слоги декодировались отдельно. Это позволило увеличить среднюю точность декодирования тонального слога до 55,7–75,6 процента. Максимальный уровень точности составил 91,4 процента. Как средняя, так и максимальная точность были значительно выше, чем у всех базовых моделей глубоких нейронных сетей. Для сравнения, сверточная нейросеть VGG16 обеспечивает среднюю точность от 15,6 до 33,4 процента, в то время как уровень шанса составляет 12,5 процента.

Искажение синтезированной речи оценивали с помощью мел-кепстрального искажения (Mel cepstral distortion, MCD), которое может отражать различия в тоне. Чем ниже MCD, тем меньше искажена речь. Медианное значение MCD для пяти участников составило от 2,67 до 3,19 децибел. А MCD четырех тонов — от 2,53 до 3,20 децибела. Чтобы речь можно было распознать, это значение не должно превышать 8 децибел.

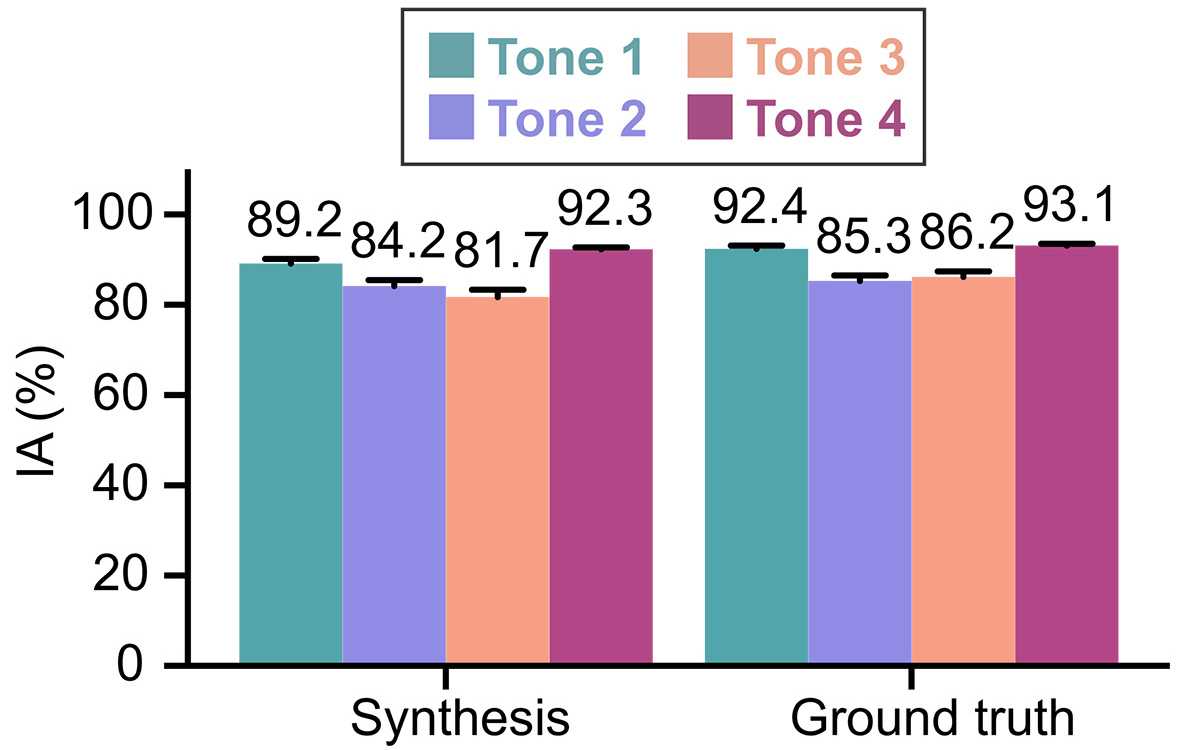

Также авторы проверили, смогут ли носители китайского определить тона синтезированных слогов. Синтезированную и реальную речь слушали 31 человек. Средний показатель разборчивости для синтезированных тонов составил от 81,7 до 92,3 процента, а для реальной человеческой речи — от 85,3 до 93,1 процента.

В дальнейшем, считают авторы, их способ проектирования нейронной сети сможет помочь декодировать непрерывную речь на китайском или других тональных языках.

Исследователи пробуют декодировать речь и другими способами. Ученые из Америки использовали для этого неинвазивную фМРТ и смогли таким образом расшифровать целые истории, которые участники слушали, смотрели или представляли.

Автор: Катерина Петрова