Каждая отрасль науки имеет свои нюансы и проблемы: например, в психологии краеугольный камень – воспроизводимость результатов, а точнее – её отсутствие.

Редкий психологический эксперимент повторяется с получением аналогичных результатов. Эта же проблема, но немного в другом виде, коснулась… искусственного интеллекта. Об этом заговорили в новостном блоге журнала Science.

Животрепещущая тема машинного обучения и ИИ оказалась не так уж и радужна. Пример тому – ситуация произошедшая с монреальскими учёными, которые хотели похвастаться новым кодом. Все было готово, оставалось только сравнить его с эталонным алгоритмом. Как только исследователи взялись за это дело, то смогли только развести руками: эталонный код-то нигде не опубликован. Своими стараниями они постарались восстановить его, исходя из описания, но за два месяца так и не приблизились к заявленной эффективности.

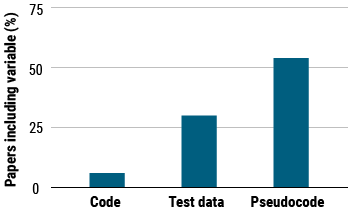

Эта история наверняка не единственная – Одд Эрик Гундерсен (Odd Erik Gundersen) из Норвежского университета науки и технологий не поленился и посчитал, что из 400 презентованных алгоритмов только 6 процентов опубликованы с кодом этого самого алгоритма. Треть исследователей делится данными, полученными в результате тестирования кода, и только половина исследователей делится хотя бы псевдо-кодом (обобщённой, неполной версией). И это включая публикации в Nature и Science!

В чём причины таких неполноценных публикаций? Их много: часть исследователей банально боятся конкуренции и не хотят, чтобы, увидев их алгоритм, кто-то сделал лучше, то есть избегают конкуренции. Другая часть учёных не имеет права публиковать свой код по причине того, что юридически он принадлежит компании или вообще в данный момент находится в разработке.

Кстати, если код все-таки опубликован – это ещё ничего не значит. Даже запустив его, вы можете получить абсолютно другие результаты, ведь машинное обучение на то и обучение, что учится посредством тренировок, узнавания и ошибок. И в каждом случае анализируемые данные – разные. Таким образом, просто по стечению обстоятельств компьютер может на основе разных данных выработать разные режимы производительности.

На встрече, проводимой Ассоциацией по развитию ИИ, Питер Хендерсон из университета Макгилла в Монреале объяснил, что система чувствительна не только к используемому коду, но и к самим предоставляемым данным, в том числе и гиперпараметрическим. Это значит, что существуют некоторые побочные факторы, влияющие на производительность и скорость обучения ИИ. По его словам, он запускал один и тот же алгоритм в разных условиях, и в итоге получил абсолютно разные результаты. Различные условия ему обеспечивала некоммерческая организация OpenAI. Хендерсон считает, что эти посторонние факторы необходимо тщательно выявлять и фиксировать. Кстати, созданный OpenAI «тренажерный зал» для ИИ в дальнейшем может получить развитие в качестве тестировочной платформы.

Ещё один инструмент для оптимизации машинного обучения был представлен IBM Research: эта компания создала платформу, которая автоматически восстанавливает неопубликованный исходных код из отрывочных сведений о нём: речи о принципах его работы, фрагментов и так далее. Он сканирует опубликованные данные, ищет диаграмму, описывающую нейронную сеть, анализирует эти данные своей «слоистой» структурой и генерирует сеть в новом коде. В настоящее время этот инструмент воспроизводит сотни опубликованных нейронных сетей, и IBM планирует сделать их доступными в открытом онлайн-хранилище.

Хоакин Ваншхорен (Joaquin Vanschoren), учёный из Технологического университета Эйнтховена в Нидерландах, создал ещё один репозиторий для потенциальных репликаторов: веб-сайт под названием OpenML. Он содержит не только алгоритмы, но и наборы данных и более 8 миллионов уже совершенных испытаний ИИ со всеми их подробностями, чтобы было по чему калиброваться.

Тем не менее проблема остается актуальной – время на тестирование даже автоматически восстановленных алгоритмов тратится, а результаты далеко не всегда удовлетворительные. Возможно, недостаток кроется ещё и не в полной мере компетентной экспертной оценке (например, ещё ни одного эксперимента из ReScience ни разу не удалось достоверно воспроизвести). Учёные призывают своих коллег быть более открытыми и не воспринимать это как приглашение опозориться. Это подразумевает лишь честность и глобальную прозрачность, без которой развитие ИИ невозможно.

Текст: Дарья Тюльганова