Группе американских и европейских ученых, которая занимается воспроизведением научных результатов, удалось успешно повторить лишь 13 из 21 работы по социальным наукам, опубликованных в Science и Nature — при этом эффект, обнаруженный в экспериментах, был в два раза слабее, чем в оригинальных работах.

Центр открытой науки (Center for Open Science) под руководством психолога Брайана Нозека (Brian Nosek), помимо прочего, занимается большими проектами по проверке воспроизводимости научных исследований. В 2015 году ученые проверили 97 работ по психологии (и воспроизвели 35), а в 2016 году попытались воспроизвести 18 экспериментальных экономических исследований (получилось в 11 случаях).

На этот раз группа отобрала и изучила 21 экспериментальную работу в области общественных наук из журналов Science и Nature 2010-2015 годов. Всего над задачей работало пять команд. В итоге ученым удалось воспроизвести три из четырех работ из Nature и 10 из 17 статей из Science, но изучаемый эффект в перепроверке был в среднем вполовину слабее эффекта в исходном исследовании.

Как сообщил Нозек, авторы предлагали свою статью о воспроизводимости в оба журнала, но те отказались ее публиковать. «Я не думаю, что им не понравились наши выводы. По моему опыту редакции обоих журналов очень открыто и вдумчиво относятся к проектам по воспроизведению исследований. Они отвергают множество статей!», — написал Нозек. Он также отметил, что пока не получил какой бы то ни было реакции от самих журналов. Nature Human Behaviour, журнал группы Springer Nature, опубликовал лишь традиционный сторонний комментарий к статье, написанный Малкольмом Маклеодом из Эдинбургского университета. На момент выхода этой новости публичной реакции от Science и Nature не было.

Все группы авторов оригинальных исследований, кроме одной, сотрудничали с Нозеком и его коллегами и, в частности, согласились с протоколом проведения исследования до его начала. Для своих репликаций ученые собирали выборки в пять раз больше, чем в оригинальных исследованиях, чтобы обеспечить достаточную статистическую мощность и гарантированно обнаружить изучаемый эффект, когда он действительно существует. В каждой статье ученые выбирали для воспроизведения один наиболее важный эксперимент (или выбирали случайно, если в работе было несколько равнозначных экспериментов). Для вынесения решения о воспроизводимости исследователи использовали, помимо простой демонстрации того же эффекта, что и в исходной работе, еще пять статистических критериев.

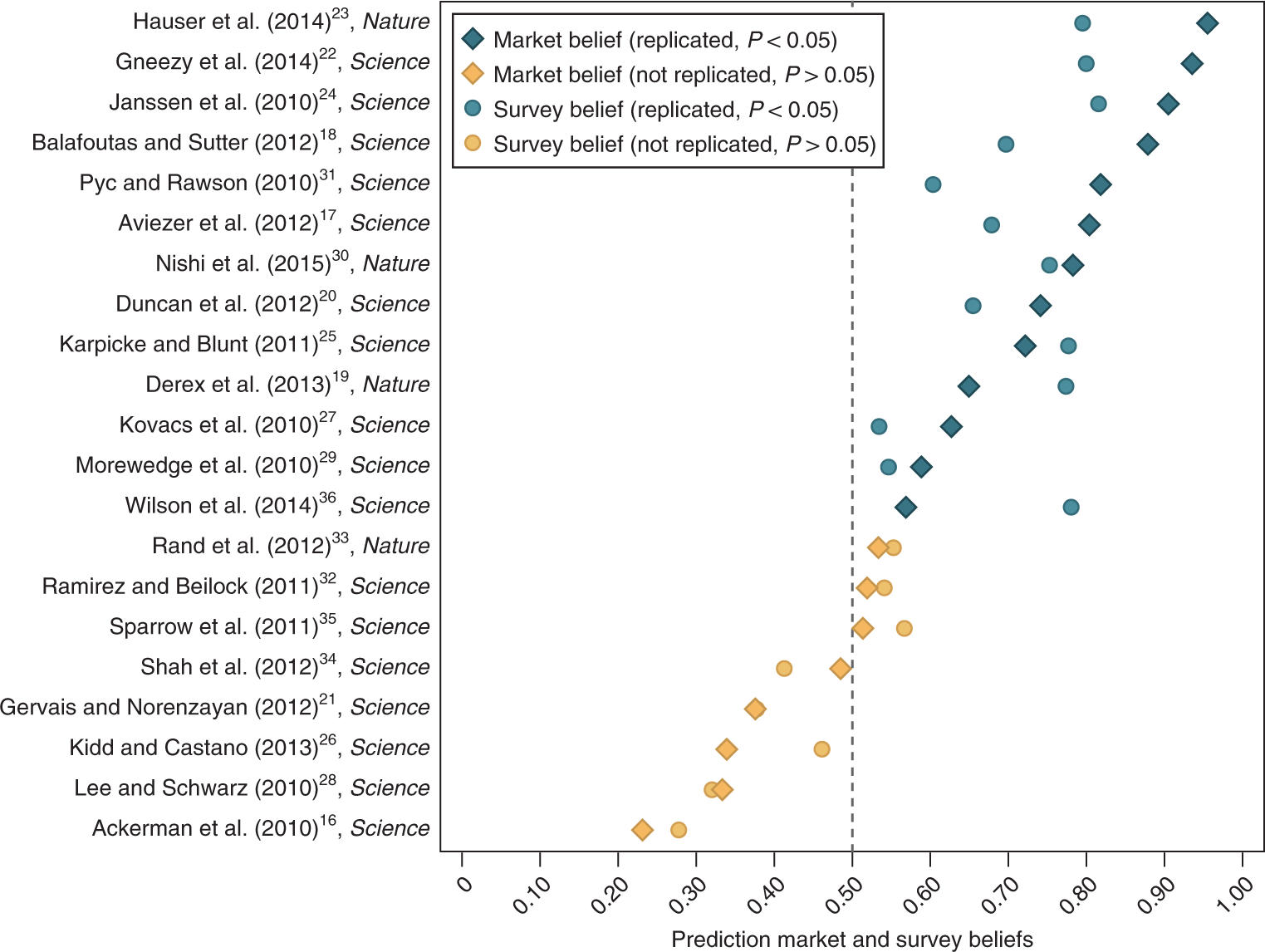

Кроме того, авторы предложили 397 коллегам-ученым с помощью опроса и рынка предсказаний оценить, получится ли успешно повторить то или иное исследование. «Мы обнаружили, что оценки воспроизводимости от других ученых сильно коррелируют с итоговой воспроизводимостью, что означает, во-первых, что научное сообщество может прогнозировать, какие работы удастся повторить, и, во-вторых, что невозможность воспроизвести исследование не была простой случайностью», — пишут ученые в статье.

Один из соавторов исследования, Гидеон Нэйв из Уортонской бизнес-школы, отметил, что сами по себе неудачи воспроизведения не означают, что исходные результаты были не верны — «возможно, ошибки в воспроизведении или различия между двумя исследованиями привели к некоторым неудачам». Однако, по его словам, способность рынка предсказаний заранее и точно оценить воспроизводимость того или иного исследования говорит не в пользу такого объяснения.

Вместе со статьей журнал опубликовал восемь сообщений от авторов исследований, которые не удалось воспроизвести, о том, почему, по их мнению, это могло случиться. Например, группа Дэвида Рэнда из Массачусетского технологического института отмечает, что с 2010 года пользователи Amazon Mechanical Turk, использовавшегося в работе, набрались опыта в экономических играх, а эффект, который ученые изучали — о связи интуитивных решений и кооперации — сильно зависит от того, играл ли испытуемый в такую игру. Одна из групп вслед за авторами проекта попыталась воспроизвести свое же исследование, и ей это не удалось.

«Масштабы невоспроизводимости исследований в различных дисциплинах означают, что пользователи научной информации не могут с уверенностью заключить, что опубликованные выводы верны. Нам или следует пытаться воспроизвести абсолютно все работы, которые мы хотим как-то использовать, или необходимо найти способ прогнозирования воспроизводимости по каким-либо параметрам исследования», — заключает в своем комментарии для журнала Малкольм Маклеод.

Нозек рассказал, что в дальнейшем планирует заняться проверкой того, работают ли меры, призванные улучшить практику проведения научных исследований. В частности, ученые уже показали, что сертификация исследований с открытыми исходными данными специальными значками в журнале Psychological Science увеличила долю работ, авторы которых дали коллегам доступ ко всей информации об эксперименте. «Сейчас мы оцениваем практику предварительного рецензирования протоколов эксперимента и хотели бы провести исследование системы пререгистрации (когда ученые публикуют протокол исследования до его проведения, а журнал обязуется опубликовать его итоги независимо от результата) — лучше ли воспроизводимость у таких исследований?», — написал Нозек.

Он также согласился с необходимостью проверить, воспроизводится ли его исследование воспроизводимости. «Ни одно исследование не может считаться окончательным. Исходные работы дают предварительные данные о том или ином феномене со степенью уверенности, определяемой размером выборку, точностью оценки и проверкой выводов. Повторы исследований дают дополнительную информацию, но они также редко оказываются окончательными сами по себе», — пояснил ученый. По его словам, именно для этого ученые использовали разные методы проверки воспроизводимости эффекта.

Статья об итогах исследования опубликована в журнале Nature Human Behaviour.

Автор: Ольга Добровидова