Исследователь из NTT Communication Science Laboratories (Япония) Томоясу Хорикава разработал метод генерации связных текстовых описаний визуального содержимого на основе активности человеческого мозга, измеренной с помощью фМРТ.

Метод «mind captionin» способен создавать структурированные предложения, отражающие не только отдельные объекты, но и взаимодействия между ними в увиденных или воображаемых сценах. Система работает даже без использования языковой сети мозга, что намекает на возможность для невербальной коммуникации пациентов с афазией. Результаты опубликованы в журнале Science Advances.

Попыток «прочитать мысли» на сегодняшний день было очень много, но ни одна не получила широкого распространения или не вышла за рамки чисто научных изысканий. До настоящего исследования декодирование визуальной семантики фокусировалось на отдельных компонентах – объектах или словах. Методы на основе баз данных с подписями ограничены существующими описаниями, а нелинейные модели могли вносить ту информацию, которой в мозге на самом деле не было. Предыдущие работы по декодированию языковой информации оказались довольно успешными для перевода услышанной речи в текст, но генерация описаний визуального опыта все еще остается сложной задачей.

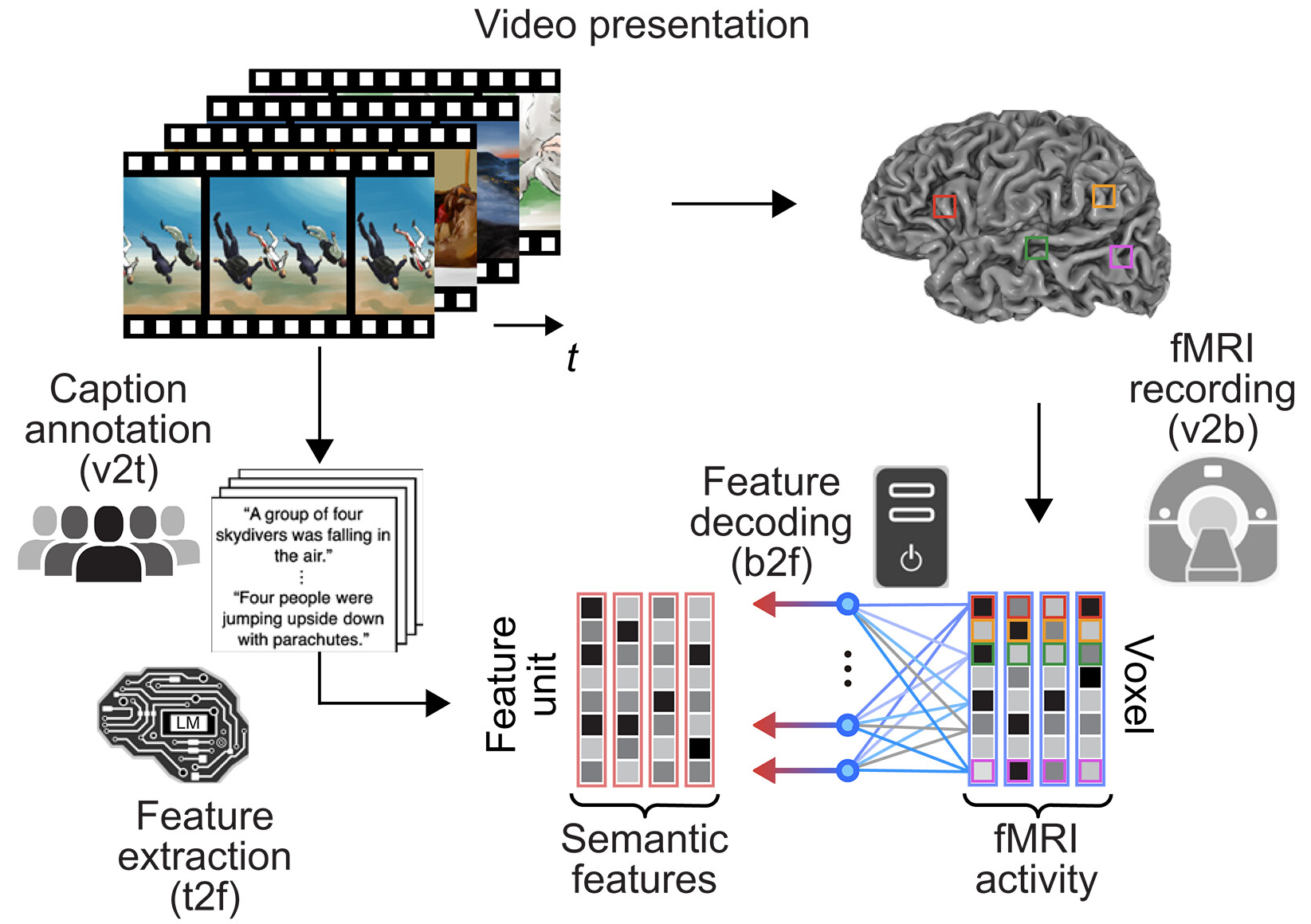

В экспериментах участвовали шесть японских испытуемых (не носителей английского языка, 22-38 лет). Методология включала два этапа. Сначала были построены линейные декодеры для перевода активности мозга на язык компьютера при просмотре 2180 видеороликов и «прикручивание» к ним семантических признаков, которые вычислялись языковой моделью DeBERTa-large из 20 текстовых подписей к каждому видео. Данные фМРТ собирались на сканере 3 Тесла с разрешением 1 секунда. Затем текст оптимизировался в три стадии: замена слов на маски, заполнение масок новыми словами с помощью модели RoBERTa-large и отбор лучших вариантов по сходству с целевыми признаками. Критически важным стало использование в этой задаче модели с двунаправленным вниманием которая, учитывает контекст со всех сторон.

В итоге описания, которые выдавала нейросеть на основе мозговой активности испытуемых, смотрящих видео, эволюционировали от бессмысленных последовательностей к связным предложениям, точно отражающим содержимое видео, включая динамические события. Точность определения видео достигла ~50% из 100 вариантов (случайный уровень 1%). Способность различать правильные и неправильные описания оказалась статистически значимо высокой.

Ключевое открытие состояло в том, что когда исследователи случайно переставляли слова в сгенерированных описаниях (например, «собака кусает змею» превращалось в «змею собака кусает»), точность резко падала. Это показывает, что метод улавливает не просто список объектов в сцене, а их взаимодействия и отношения – кто что делает и с кем. Даже когда исследователи выбирали самые грамматически правильные варианты с переставленными словами, оригинальные описания все равно оказывались в топ-0,001% по точности среди тысячи вариантов. Это доказывает, что конкретный порядок слов определяется информацией, закодированной в мозге, а не случайностью.

Анализ областей мозга показал, что точные описания генерируются без учета активности языковой сети. Исключение языковой сети обеспечивало почти 50% точность (усредненно по испытуемым) с сохранением чувствительности к порядку слов. Семантическая модель эффективно предсказывала активность в областях, связанных с распознаванием объектов, действий и взаимодействий в высшей зрительной коре и теменно-фронтальных областях.

Метод обобщился и на воспоминания: декодеры, обученные на восприятии, генерировали описания припоминаемых видео с точностью до 40% у лучших испытуемых. Самыми «способными» для переноса и сохранными между восприятием и воображением оказались семантические признаки по сравнению с визуальными. Метод работал даже на данных одной пробы фМРТ при воображении.

Сравнение показало превосходство над поиском по базам данных (4,1 млн готовых подписей) и методом автоматического подписывания изображений на основе нейросетей на данных видео и фотографий. Метод точнее отражал субъективные восприятия испытуемых и был устойчив при использовании различных языковых моделей.

Авторы подчеркивают, что метод представляет интерпретирующий интерфейс между мыслями и текстом, а не прямое чтение мыслей. Генерируемые тексты отражают как информацию из мозга, так и знания о мире, встроенные в модели. Ключевым ограничением стало то, что использование естественных видео затрудняет оценку работы метода на необычных сценах. Вербальные подсказки для припоминания могли влиять на активность мозга. Подписи от независимых людей могут не полностью отражать индивидуальные восприятия. В качестве этических вопросов ученые поднимают риски непреднамеренного раскрытия мыслей и искажения из-за предвзятости моделей.

Тем не менее, несмотря на ограничения, исследование открывает новые возможности для интерфейсов мозг-компьютер и коммуникации при нарушениях речи.

Текст: Анна Хоружая